- merci! Utile

- Pas utile

- Pas sûr

chargement des résultats

chargement des résultats

Dans ce groupe posez vos questions et partagez vos astuces, ressources, outils, jobs etc sur la Vision de l'enfant.

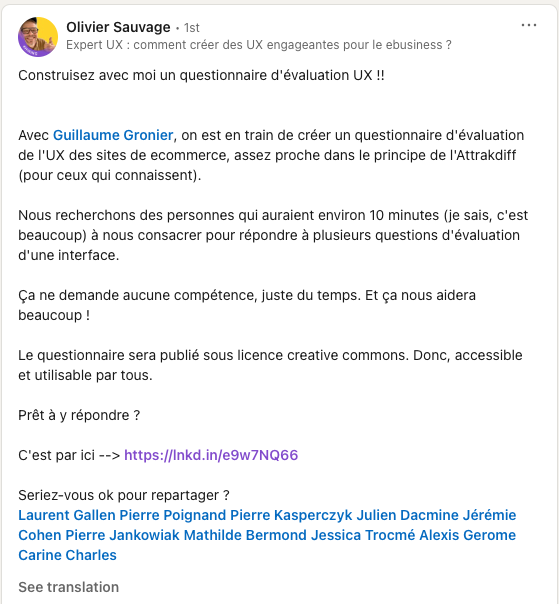

Participez-ici: http://guillaumegronier.com/uxm/

Participez-ici: http://guillaumegronier.com/uxm/

La solution que j’utilise depuis plusieurs mois s’appelle MacWhisper. Comme son nom l’indique, c’est une application pour Mac qui utilise le modèle Open Source Whisper d’OpenAI. L’interface de l’outil est perfectible et il manque la détection automatique des participants (il faut les indiquer à la main pour l’instant) mais la qualité de transcription est excellente en anglais et très bonne en français (au début il faut tester avec les différents modèles pour voir ce qui convient le mieux à chaque situation mais une fois qu’on est calé, c’est super et surtout très rapide). Sur les interviews pour lesquelles j’ai utilisé MacWhisper (plusieurs dizaines d’heures en anglais et en français, avec différents accents), j’ai trouvé les résultats bien meilleurs qu’avec Dovetail par exemple.

La solution que j’utilise depuis plusieurs mois s’appelle MacWhisper. Comme son nom l’indique, c’est une application pour Mac qui utilise le modèle Open Source Whisper d’OpenAI. L’interface de l’outil est perfectible et il manque la détection automatique des participants (il faut les indiquer à la main pour l’instant) mais la qualité de transcription est excellente en anglais et très bonne en français (au début il faut tester avec les différents modèles pour voir ce qui convient le mieux à chaque situation mais une fois qu’on est calé, c’est super et surtout très rapide). Sur les interviews pour lesquelles j’ai utilisé MacWhisper (plusieurs dizaines d’heures en anglais et en français, avec différents accents), j’ai trouvé les résultats bien meilleurs qu’avec Dovetail par exemple.

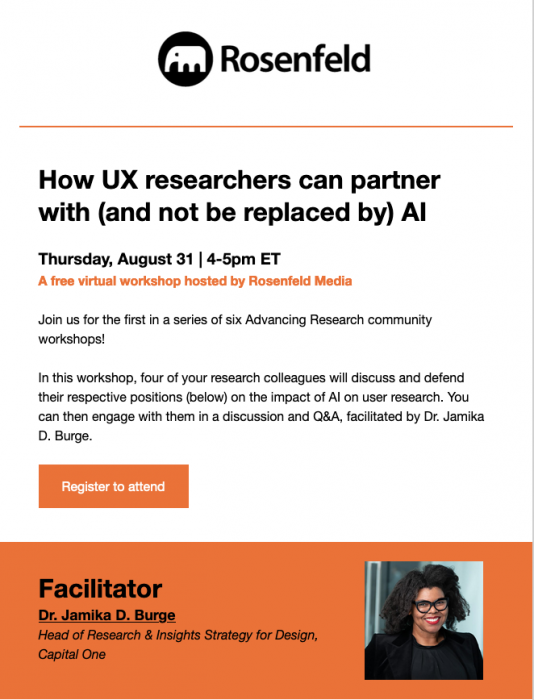

Lien d'inscription: https://us02web.zoom.us/meeting/register/tZ0rde2upjwsHtCC_IOHK6aeY01wWHBnne6H?mc_cid=5cad4cd451&mc_eid=fc3b5fcc9f#/registration

Lien d'inscription: https://us02web.zoom.us/meeting/register/tZ0rde2upjwsHtCC_IOHK6aeY01wWHBnne6H?mc_cid=5cad4cd451&mc_eid=fc3b5fcc9f#/registration

MÉTAPHORE 2: Le bourré qui cherche ses clés sous le lampadaire J'utilise cette métaphore surtout dans des situations où les équipes mentionnent que personne ne s'est plaint Les typiques: "On n'a jamais eu de feedback dessus. Pourquoi faire de la recherche ?" "Tout marche très bien"

MÉTAPHORE 2: Le bourré qui cherche ses clés sous le lampadaire J'utilise cette métaphore surtout dans des situations où les équipes mentionnent que personne ne s'est plaint Les typiques: "On n'a jamais eu de feedback dessus. Pourquoi faire de la recherche ?" "Tout marche très bien"

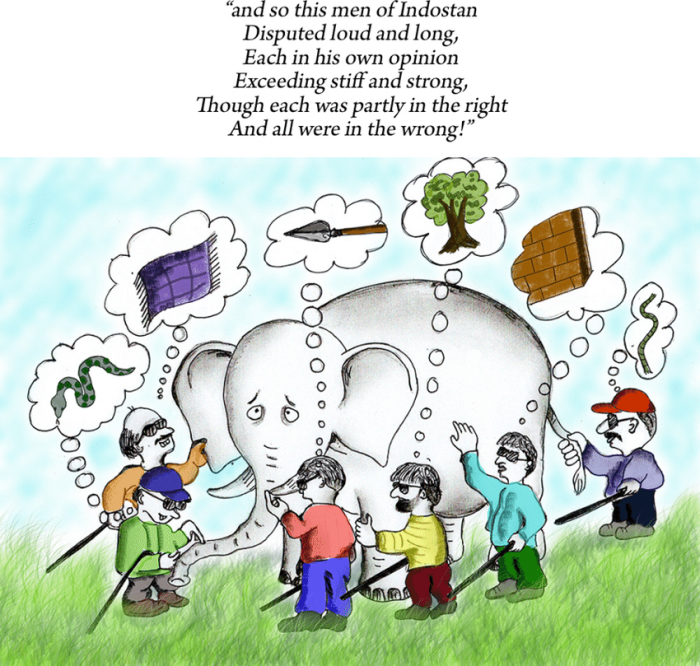

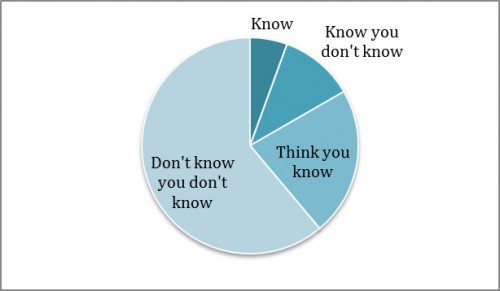

MÉTAPHORE 3: you don't know what you don't know A utiliser en combinaison des deux autres situations pour visualiser la connaissance lors d'un workshop, ou lorsque vous êtes dans des équipes un peu plus matures en research et qui commence à prendre confiance dans la research. (J'observe qu'après un certain niveau certaines équipes ne cherchent pus à apprendre et croient connaître) Donc lors d'un workshop j'utilise cela avec un tableau d'hypothèses priorisées par niveau de preuves déjà existantes. Dans un Figjam lorsque vous dezoomez cela permet de comparer entre ce que l'on connait et ne connait pas. Très efficace pour rester humble.

MÉTAPHORE 3: you don't know what you don't know A utiliser en combinaison des deux autres situations pour visualiser la connaissance lors d'un workshop, ou lorsque vous êtes dans des équipes un peu plus matures en research et qui commence à prendre confiance dans la research. (J'observe qu'après un certain niveau certaines équipes ne cherchent pus à apprendre et croient connaître) Donc lors d'un workshop j'utilise cela avec un tableau d'hypothèses priorisées par niveau de preuves déjà existantes. Dans un Figjam lorsque vous dezoomez cela permet de comparer entre ce que l'on connait et ne connait pas. Très efficace pour rester humble.

Ce qui manque actuellement et ce que j'aimerais voir se développer, c'est une culture de challenge entre les chercheurs, similaire à celle des designers. Les chercheurs sont souvent un peu solitaires. Il y a UN chercheur et DES designers. Du coup nous commençons à mettre cela en place en interne, avec les différentes équipes UX dans les différents pays. Nous organisons des moments dédiés où nous discutons d'outils et de méthodes. Tout comme il y a des revues de design, nous mettons en place des revues de recherche où nous pouvons présenter nos sujets de recherche aux autres. Il m'arrive encore aujourd'hui de mettre un mois, voire un mois et demi, avant de bien comprendre certains sujets sur lesquels je travaille. C'est là que tout devient clair : "Ah, en fait, tu pourrais le faire comme ça." Dans certaines entreprises l'écosystème peut être très complexe, avec de nombreux services différents, et cela peut être nébuleux. Nous nous efforçons de créer des workflows pour guider nos démarches. Ainsi, lorsqu'il s'agit de mener une discovery, nous savons comment procéder, et lorsque nous réalisons des tests, nous avons une méthodologie à suivre. C'est pourquoi il est essentiel d'avoir des modèles prédéfinis pour nous aider à structurer et à standardiser notre travail, et les research reviews en font parties.

Ce que j'aurais aimé au début de ma carrière, c'est que l’on me dise l’importance de mieux comprendre l'organisation dans laquelle on travaille au-delà du produit. Pour comprendre cela il faut comprendre mon parcours. J’ai un cursus universitaire, en sociologie et anthropologie et j’ai bifurqué vers le design à la fin de ma thèse. Quand l’UX est arrivé la double casquette m’a permis de tout de suite être à l’aise. Mais le rôle propre d’UX Researcher, c’est dans mon précédent emploi que je l’ai pris en premier, il y a 4 ans. Lorsque tu es designer tu as l’habitude de travailler sur des interfaces, tu produis des choses. Mais un researcher c’est plus que ça. Il produit de la connaissance, il produit plein de connaissances pour le design mais aussi sur l’ensemble du process produit et c’est hyper important. Je crois qu'aujourd'hui, le sujet sur lequel je suis le plus affûtée, c’est de bien comprendre l’organisation du produit. En arrivant dans mon précédent emploi, j’ai mis du temps à comprendre l’organisation produit. Parce que finalement le researcher est dans le process produit, l’interface entre le PM et le design. J’ai vraiment eu besoin de bien comprendre les process et les rôles de chacun et aussi les interactions entre les équipes Encore aujourd'hui, ce n’est pas forcément toujours facile. L'entreprise dans laquelle je travaille actuellement est une grosse entreprise. L'avantage que j'ai, c'est qu'elle est hyper bien structurée. On a beaucoup de rituels, donc on peut bien voir comment ça fonctionne. Les PM avec qui je travaille qui sont les PM front, nous intègrent dans leurs rituels de dev, et nous, on les intègre dans nos ateliers de construction, de co-conception et de recherche aussi. C'est notre manière, de bien comprendre et connaître la manière dont on travaille les uns et les autres. Parce que souvent comme researcher, tu vas te retrouver dans la situation où on va dire “Vas-y, il faut qu'on ait des insight utilisateurs sur tel sujet” Mais tu ne comprends pas dans quel objectif ça s’inscrit, dans quel roadmap, etc. Maintenant, dans mon équipe, on a construit un template de briefs pour se demander à chaque fois pourquoi on veut faire ce sujet de recherche Quels sont les objectifs business ? Comme ça, on sait bien ce qu'on fait, pourquoi on le fait et comment on rend toute la recherche activable pour les parties prenantes.